728x90

1-1. LLM 은 무엇인가?

- LLM(Large Language Model)

- 언어 모델(Language Model) : 어린 아이에게 글을 가르치듯이 컴퓨터에게 어떻게 말을 하고 글을 쓰는 지 가르치는 것과 같음

- 🌟 언어 모델의 발전과 관련하여 몇 가지 변곡점 존재

1-1-1. 언어 모델

통계적 언어 모델

- 초기 모델 : 통계적 방법에 기반

- 컴퓨터가 문장이나 단어를 얼마나 자연스럽게 표현하는가

- 언어 모델에서의 확률/통계적 방법

- n-gram: 일련의 단어나 문자가 얼마나 자주 함께 나타나는가.

- 💡 이때,

n은 연속적으로 고려되는 단어의 수를 말한다.

- 1-gram(유니그램) : 전체 문장을 각각의 단어로 나눔

- e.g.

The/cat/sat/on/the/mat

- e.g.

- 2-gram(바이그램) : 전체 문장을 두 단어씩 나눔

- e.g.

The cat/cat sat/sat on/on the/the mat - c.f. 단어가 겹쳐야한다.

- e.g.

- 3-gram(트라이그램) : 전체 문장을 세 단어씩 나눈다.

- e.g.

The cat sat/cat sat on/sat on the/on the mat - c.f. 바이그램과 동일하게, 단어가 겹쳐야한다.

- e.g.

- n-gram 을 이용해서 다음 단어를 예측하는 데에 사용함

- e.g. 만약

The cat sat on다음 단어를 예측할 때,sat on다음에 자주 등장하는 단어를 서칭함 - ∴ 언어의 통계적 패턴을 학습하고 문장을 이해함 ⇢ new 문장 생성

- But, 가능한 모든 n-gram을 DB에 저장하고 있어야함

신경망 언어 모델

👉🏻 DNN 기반의 모델을 통해 앞선 DB 중심의 한계를 해결

Neural Network Language Model

- 일반적인 뉴런 기반의 언어 모델

- RNN(Recurrent Neural Networks)

- 시퀀스 데이터 처리에 적합

- 과거의 데이터 ➡ 현재의 결정에 영향

- LSTM(Long Short-Term Memory Networks)

- RNN의 시퀀스 데이터 처리에 대한 한계 극복

Transformer

- 트랜스포머 아키텍처의 도입으로 문장과 단락 전체에 대한 처리가 가능해짐

- LLM은 자연어에서 인간의 의도를 심층적이고 맥락에 맞게 이해

- 콘텐츠 생성, 문장 요약 등에 대한 활용 확장

e.g.

- BERT(Bidirectional Encoder Representations from Transformers)

- 텍스트를 양방향으로 분석하여 맥락을 이해

- 양방향 텍스트 분석? ⇢ 언어 모델이 단어 앞뒤 문맥을 고려함

- GPT(Generative Pretrained Transformer)

- GPT 모델은 다른 언어 모델에 비해 자연스러운 텍스트 생성 및 높은 수준의 대화를 진행

1-1-2. 거대 언어 모델(LLM)

- LLM(Large Language Model)

- _대규모 데이터_로 훈련된 매우 큰 규모의 인공 지능 기반 언어 모델

🤔 아무리 많은 데이터로 학습을 진행했다하더라도 다 거대 언어 모델이라고는 할 수 없음

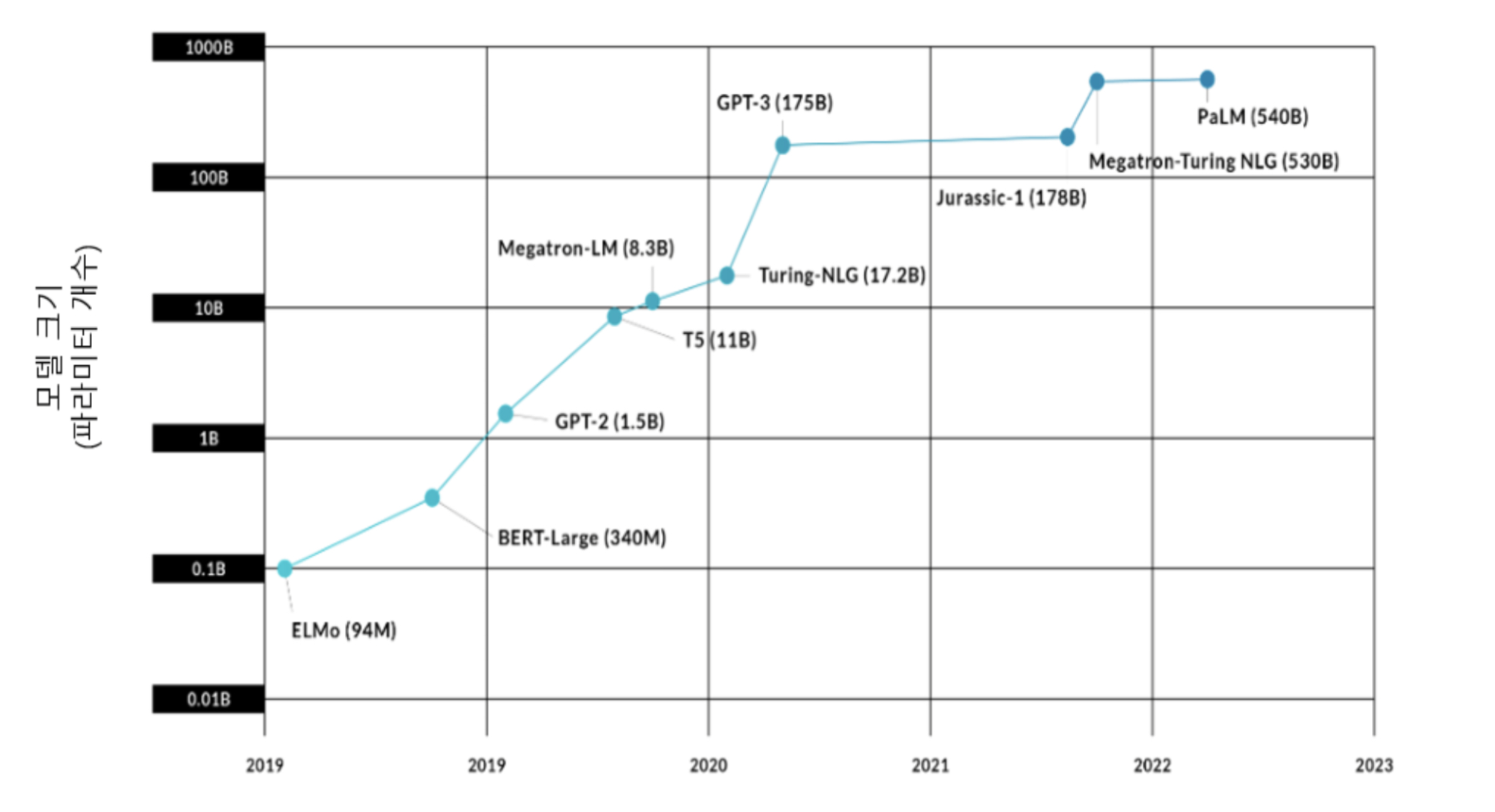

- 모델의 크기: 주로 모델이 가지고 있는 파라미터 수로 측정

모델과 파라미터 사이의 상관관계

1-2. LLM

1-2-1. LLM의 특징

- 방대한 텍스트 데이터로 부터 학습

- 언어의 이해와 생성에 있어서 특화

- 특정 작업을 위한 파인튜닝 가능

- LLM 훈련에 있어서 많은 컴퓨팅 자원 필요

1-2-2. LLM의 종류

- Infrasturcture Layer : NVIDIA를 포함한 하드웨어/모델 제공 오픈 AI/Hugging face

- Application Layer : 코드로 구현 가능한 프레임 워크/서비스로 활용할 수 있는 BI 툴 제공

+) GPT-4 부터 멀티모달을 지원한다.

⇢ 멀티모달? '여러 방법을 섞어 쓴다'는 뜻으로, 보고 / 듣는 두 방법을 같이 쓰는 경우가 여기에 해당

⇢ 사진, 글, 음성 등 여러 종류의 정보 처리를 제공

1-2-3. LLM 🆚 GAI 🆚 SLM

- LLM

- 거대 언어 모델

- 대용량 텍스트 데이터 학습 ⇢ 인간의 언어 자연어 이해 및 생성

- ∴ 텍스트 기반으로 질답, 글 작성, 대화 등 다양한 언어 관련 작업 시 사용

- GAI

- 입력 데이터를 기반으로 새로운 콘텐츠를 생성하는 AI

- 다양한 형태의 콘텐츠 생성

- ∴ LLM 보다 GAI 가 더 큰 범위의 인공지능

| 구분 | GAI | LLM |

|---|---|---|

| 콘텐츠 생성 범위 | 텍스트, 이미지, 음성 등 | 텍스트 국한 |

| 학습 | 대규모 데이터 의존 But, 이미지/오디오 등 다양한 데이터 유형 학습 | 인터넷, 서적 및 기타 광범위한 텍스트 학습 |

| 출력 | 음약 ~ 예술까지 광범위한 출력 생성 | 사용자 질문에 일관되고 상황에 맞는 텍스트 생성 |

| 신경망 | 이미지를 위한 GAN 음악 같은 시퀀스 데이터를 위한 RNN 을 포함한 다양한 모델 사용 | 텍스트에 효과적인 RNN, 트랜스포머 사용 |

| 분야 | 여러 분야 활용 가능 | 언어 관련 작업 특화 |

728x90

'🤖 AI' 카테고리의 다른 글

| [OCR] EasyOCR 손글씨 및 한국어 Fine Tuning (0) | 2023.05.31 |

|---|---|

| [DNN] 신경망의 구조 (0) | 2022.02.07 |

| [DNN] 그래디언트, 옵티마이저 정리 (0) | 2021.10.02 |

| [CNN]CNN모델의 이해 (0) | 2021.09.20 |

| [Tensorflow_Keras_API] tf.keras.utils.get_file : 데이터 다운로드 메서드 (0) | 2021.07.21 |